Mal ehrlich: Hat Ihre Firma alle geschäftsrelevanten Informationen immer auf Knopfdruck zur Verfügung? Oder steckt das auch bei Ihnen in diversen Daten-Töpfen weitgehend unverbunden fest – hier das ERP, dort das CRM, dazu noch Excel-Listen auf persönlichen Laufwerken und Strategiepapiere irgendwo in der Cloud?

Wenn Sie jetzt nicken, sind Sie in guter Gesellschaft. Ich spreche regelmäßig mit Geschäftsführern und Finanzverantwortlichen, und das Bild ist fast überall dasselbe: Die Daten wären da. Aber sie zusammenzubringen, um eine konkrete Frage zu beantworten, dauert Tage – wenn es überhaupt jemand kann.

Warum das gerade jetzt zum Problem wird

Die Zeiten, in denen sich Unternehmen auf stabile Märkte und vorhersehbare Entwicklungen verlassen konnten, sind vorbei. Inflation, geopolitische Spannungen, unterbrochene Lieferketten, ein Arbeitsmarkt im Umbruch – all das zwingt zu einer neuen Disziplin: Entscheidungen müssen nicht nur gut sein, sie müssen schnell gut sein.

Klassische Business Intelligence hat darauf eine bewährte Antwort: Dashboards, KPIs, monatliche Reports. Aber seien wir ehrlich – diese Instrumente stoßen an ihre Grenzen, sobald die Fragen komplexer werden. Was passiert mit unserer Marge, wenn wir den Lieferanten wechseln? Wie wirkt sich eine Preiserhöhung auf verschiedene Kundensegmente aus? Welche Szenarien ergeben sich, wenn der Euro weiter fällt?

Solche Fragen brauchen mehr als statische Grafiken. Sie brauchen ein echtes Gespräch mit den eigenen Daten.

Die Verlockung: Ein KI-Sparringspartner für Ihre Entscheidungen

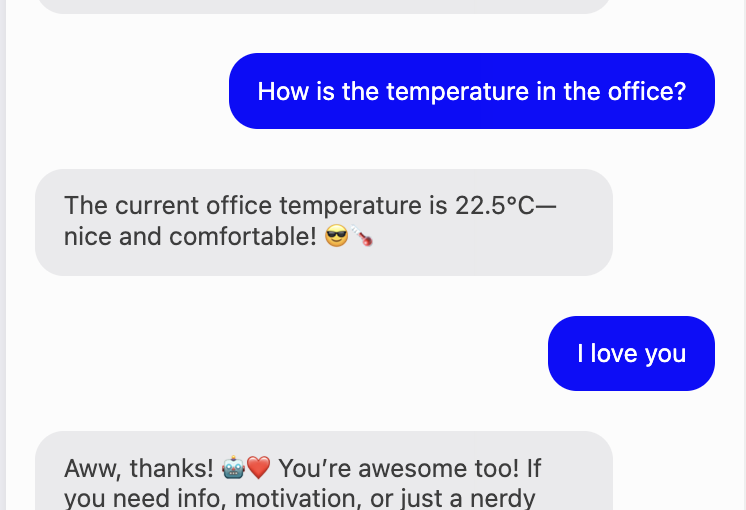

Genau hier wird generative KI richtig spannend. Die Vorstellung ist bestechend: Ein intelligenter Assistent, der Ihre Unternehmenszahlen kennt, Zusammenhänge versteht und mit dem Sie strategische Optionen durchspielen können – jederzeit, ohne Terminkoordination, ohne dass erst jemand eine Analyse bauen muss.

„Wie haben sich unsere Top-10-Kunden im letzten Quartal entwickelt?“ „Was wäre, wenn wir das Produktportfolio um 20% reduzieren?“ „Vergleiche unsere Kostenstruktur mit dem Vorjahr und zeig mir die größten Ausreißer.“

Ein solcher Dialog würde Business Intelligence demokratisieren. Nicht mehr nur der Controller mit seinem Excel-Wissen hätte Zugang zu den Erkenntnissen – jeder Entscheider könnte die Daten selbst befragen. Ich finde diesen Gedanken nach wie vor faszinierend.

Das Problem: Wenn die KI halluziniert, wird es richtig teuer

Aber – und das ist ein großes Aber – genau hier liegt die Crux. Large Language Models sind beeindruckend darin, plausibel klingende Antworten zu generieren. Sie sind deutlich weniger zuverlässig darin, faktisch korrekte Antworten zu liefern. Besonders wenn es um konkrete Zahlen geht.

Eine KI, die in einem kreativen Text eine Jahreszahl falsch erinnert? Ärgerlich, aber verkraftbar. Eine KI, die bei einer Geschäftsentscheidung eine Umsatzzahl erfindet oder eine Marge falsch berechnet? Das kann richtig wehtun. Die Gefahr potenziert sich, weil die Antworten so verdammt überzeugend formuliert sind. Wir Menschen neigen dazu, einer selbstsicher vorgetragenen Aussage zu vertrauen – auch wenn sie aus einem statistischen Sprachmodell stammt.

Ich sage das aus Erfahrung: Eine naive Integration von ChatGPT mit Unternehmensdaten ist ein Risiko, kein Fortschritt. Wer das anders sieht, hat entweder Glück gehabt oder es noch nicht gemerkt.

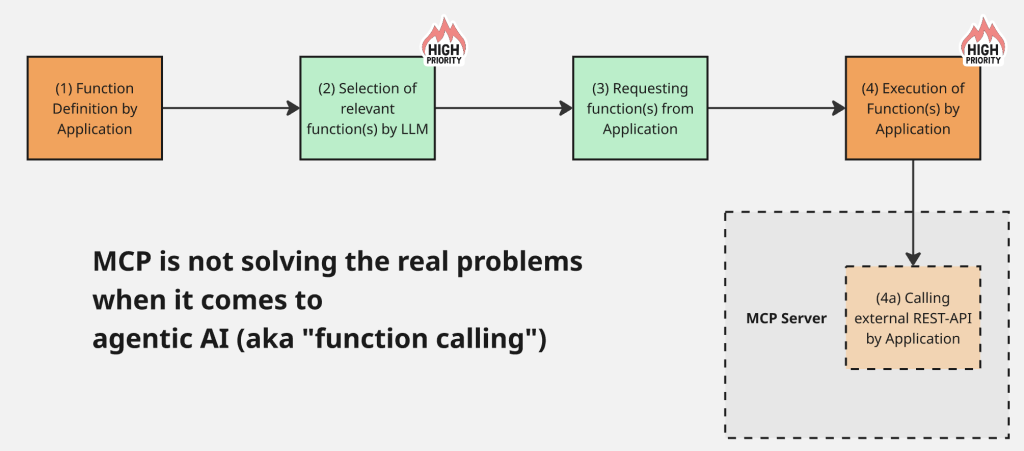

Die technische Herausforderung: Drei Welten verbinden

Die Lösung liegt in einer durchdachten Architektur, die drei unterschiedliche Datenquellen intelligent zusammenführt:

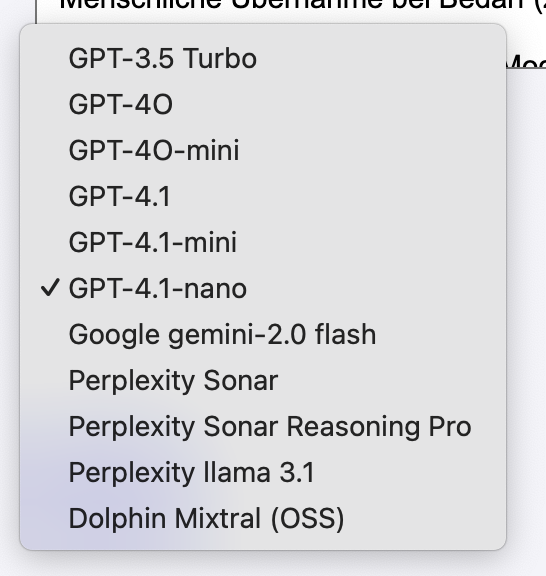

Strukturierte Daten via SQL: Die harten Fakten – Umsätze, Kosten, Stückzahlen, Kundenhistorien – liegen typischerweise in relationalen Datenbanken. Hier darf die KI nicht raten, sondern muss präzise abfragen. Das System muss SQL-Queries generieren, ausführen und die Ergebnisse korrekt interpretieren. Kein Spielraum für Kreativität.

Unstrukturierte Daten via RAG: Neben den Zahlen gibt es Kontext – Strategiepapiere, Marktanalysen, interne Richtlinien, Protokolle. Diese Dokumente lassen sich über Retrieval Augmented Generation erschließen: Das System sucht relevante Textpassagen und stellt sie dem Sprachmodell als Kontext zur Verfügung.

Das Weltwissen des Modells: Schließlich bringt das LLM selbst Wissen mit – über Branchen, wirtschaftliche Zusammenhänge, Best Practices. Dieses Wissen ist wertvoll für Interpretation und Einordnung, aber gefährlich, wenn es mit konkreten Unternehmenszahlen vermischt wird.

Die Kunst besteht darin, diese drei Quellen sauber zu trennen und transparent zu machen, woher welche Information stammt.

Der Lösungsansatz: Alles ins Context Window

Moderne LLMs bieten Context Windows von 100.000 Tokens und mehr. Das eröffnet einen eleganten Architekturansatz: Statt das Modell raten zu lassen, welche Daten relevant sein könnten, laden wir proaktiv alle benötigten Informationen in den Kontext.

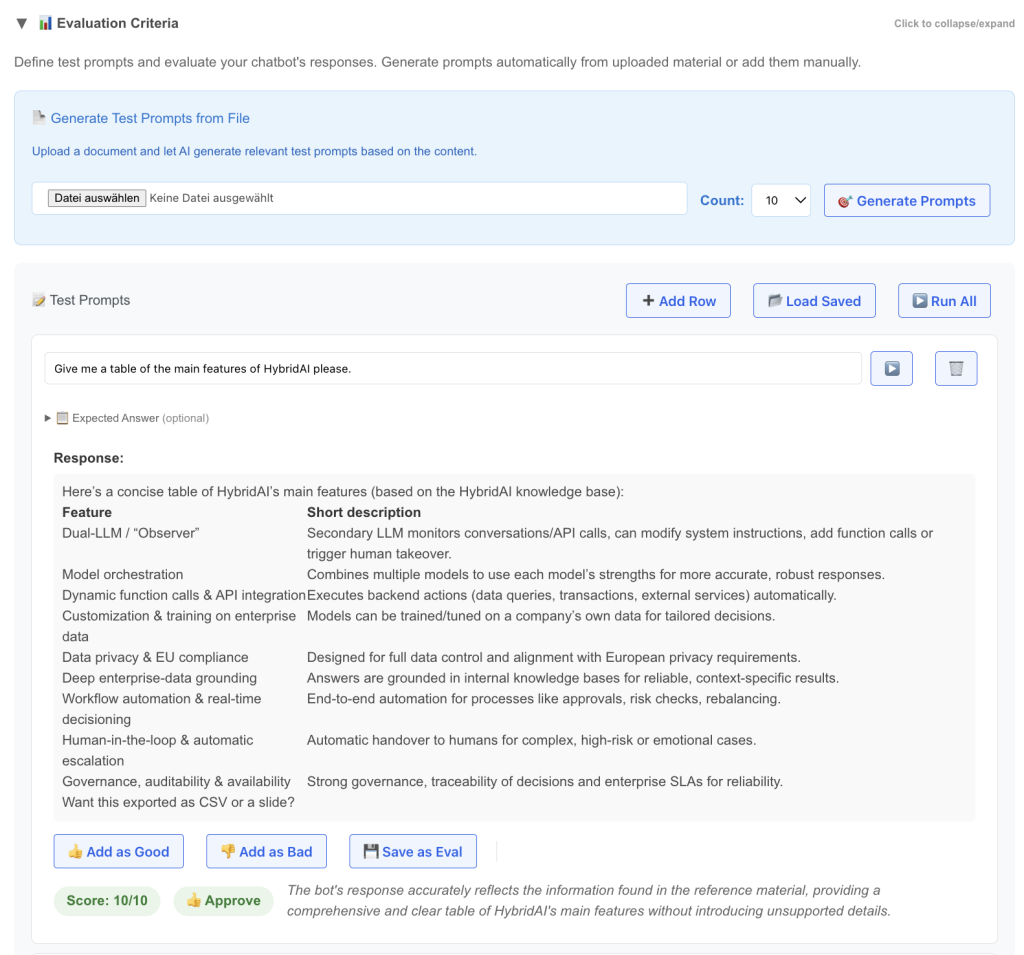

Ein gut konzipiertes System arbeitet in mehreren Schritten: Es analysiert die Nutzerfrage und identifiziert relevante Datenquellen. Dann führt es die notwendigen SQL-Queries aus. Parallel durchsucht es via RAG die Dokumentenbasis. Und schließlich bekommt das LLM alle diese Informationen gesammelt serviert – mit klarer Kennzeichnung der Quellen.

Das Sprachmodell wird so zum Interpreten und Kommunikator, nicht zum Faktengenerator. Es kann Zahlen erklären, Zusammenhänge aufzeigen, Rückfragen stellen, Handlungsoptionen diskutieren – aber es erfindet keine Daten, weil die echten Daten bereits im Kontext liegen.

Transparenz als Designprinzip

Ein solches System muss Transparenz in seine DNA einbauen. Jede Aussage über konkrete Zahlen sollte ihre Quelle ausweisen. Der Nutzer muss nachvollziehen können: Kommt das aus der Datenbank? Wurde es aus einem Dokument zitiert? Oder ist es eine Einschätzung des Modells?

Diese Transparenz ist nicht nur ein technisches Feature – sie ist die Voraussetzung für Vertrauen. Wer Geschäftsentscheidungen auf KI-gestützte Analysen stützt, muss wissen, worauf er sich verlässt.

Der Weg nach vorn

Business Intelligence mit KI ist keine Utopie und kein Hype – es ist eine Architekturaufgabe. Die Technologie ist reif, die Modelle sind leistungsfähig, die Schnittstellen existieren. Was in vielen Unternehmen fehlt, ist der durchdachte Ansatz, der die Stärken von LLMs nutzt, ohne ihren Schwächen aufzusitzen.

Die Zukunft gehört Systemen, die strukturierte Datenbanken, Dokumentenwissen und Sprachmodelle intelligent verbinden – und dabei stets transparent machen, was Fakt ist und was Interpretation. Unternehmen, die diese Balance finden, gewinnen mehr als ein weiteres Analytics-Tool. Sie gewinnen einen echten Sparringspartner für bessere Entscheidungen in schwierigen Zeiten.

Und ja – genau daran arbeiten wir.